共计 1230 个字符,预计需要花费 4 分钟才能阅读完成。

B站俨然成了一个学习的网站,有很多有用的资源,但是哪些是大浪淘沙后的精品资源呢?这就要我们做一下筛选了,借用python工具就可以实现。

开发环境:

Windows10 + python3

准备工作

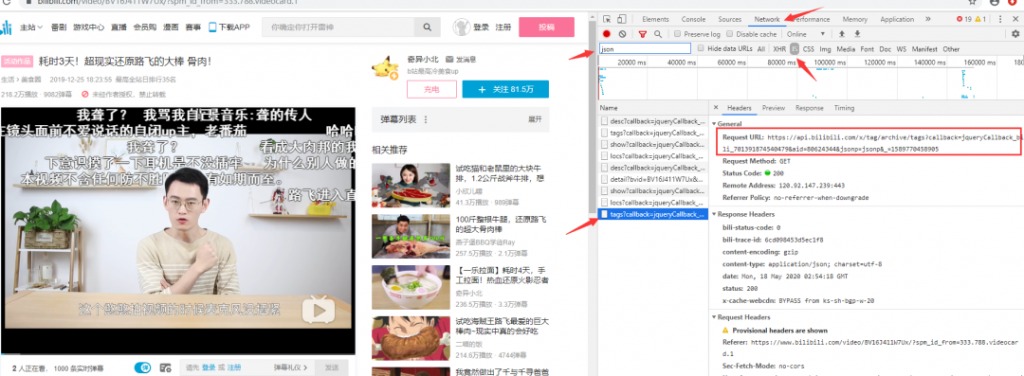

打开 B 站,随便在首页找一个视频点击进去。

常规操作,打开开发者工具(F12)。

通过爬取 B 站提供的 api 来获取视频信息。

关键点我已经筛选出来了

找到了 api 的地址去除没必要的内容,得到https://api.bilibili.com/x/web-interface/archive/stat?aid=80624344 ,

用浏览器打开,会得到如下的 json 数据

{

"code": 0,

"message": "0",

"ttl": 1,

"data": {

"aid": 80624344,

"bvid": "BV16J411W7Ux",

"view": 2181829,

"danmaku": 9082,

"reply": 2224,

"favorite": 21003,

"coin": 83049,

"share": 3722,

"like": 193342,

"now_rank": 0,

"his_rank": 35,

"no_reprint": 1,

"copyright": 1,

"argue_msg": "",

"evaluation": ""

}

}核心工作

好了,到这里代码就可以码起来了,通过 request 不断的迭代获取数据,为了让爬虫更高效,可以利用多线程。

核心代码

result = []

req = requests.get(url, headers=headers, timeout=6).json()

time.sleep(0.6) # 延迟,避免太快 ip 被封

try:

data = req['data']

video = (

total,

data['aid'], # 视频编号

data['view'], # 播放量

data['danmaku'], # 弹幕数

data['reply'], # 评论数

data['favorite'], # 收藏数

data['coin'], # 硬币数

data['share'] # 分享数

)

with lock:

result.append(video)

if total % 100 == 0:

print(total)

total += 1

except:

pass

迭代爬取

urls = ["http://api.bilibili.com/archive_stat/stat?aid={}".format(i)

for i in range(10000)]

with futures.ThreadPoolExecutor(32) as executor: # 多线程

executor.map(run, urls)整个项目的最主要部分的代码也就是 20 行左右,挺简洁的。

爬完全站信息也就几天时间。

收尾工作:

数据爬取后要怎么处理就看自己了,可以保存为 csv 文件,也可以汇总插入到数据库。

[打开微信]->[扫描下方二维码]->[关注数据与人],后台回复”B站爬虫脚本” 获取下载链接,即可获取全部代码

以上就是全部内容了。

正文完

发表至: 资源

2023-10-10